ロジスティック回帰: 確率を予測する鍵【東京情報大学・嵜山陽二郎博士のAIデータサイエンス講座】

ロジスティック回帰分析は、2値のカテゴリカル目的変数を予測するための統計手法です。目的変数の確率を対数オッズ(ロジット)に変換することで、線形モデルの形を維持しながら、0から1の間に収まる確率を予測します。この変換により、目的変数の範囲が[−∞, ∞]に広がり、予測精度が向上します。しかし、ロジスティック回帰モデルは等分散性の仮定を満たさないため、最小二乗法ではなく最尤推定法を使用して回帰係数を推定します。最尤推定法は、観測されたデータが得られる確率(尤度)を最大化するパラメータを見つけ出す方法です。この方法により、ロジスティック回帰分析では、具体的なデータに基づいて、確率的な予測を行うことができます。

![]() ▼▼▼▼▼▼▼▼

▼▼▼▼▼▼▼▼

チャンネル登録はこちら

ロジスティック回帰分析

ロジスティック回帰分析は、説明変数が連続変数で、目的変数が2値のカテゴリカル変数(あるなし、生存死亡など)で、目的変数を予測する場合に有効な手法です。

説明変数は1つでも、多数でも(多変量解析)可能です。先ずは説明変数が1つの場合を考えてみましょう。

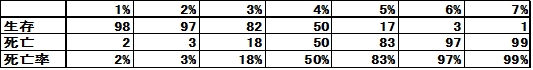

試験管内で、大腸菌にいろいろな濃度のエタノールを加え、生存する菌の数(100個あたり)を調べたところ、以下の結果が得られました。

先ずこの結果から、少々のエタノールの濃度(1〜2%)では、大腸菌は死なないことがわかります。

一方、6〜7%でほとんどの大腸菌は死亡するので、これ以上濃度を高くしても意味がないことがわかります(脚注⇒実際の消毒用エタノールは70〜80%で使われていますが、このような試験管内の実験では7%で十分ということです)。

さて、これを縦軸死亡率、横軸濃度として散布図を描くと以下のようになります。

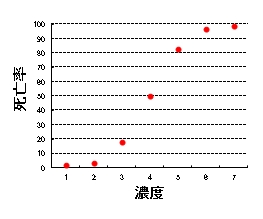

さて、このようなS字のデータの場合、中央は比較的予測しやすいですが、上と下は予測が難しいのです。

なぜなら、少しくらい横軸を変化させたところで、値が変わらないからです。

そこで、このような場合ロジット変換という手法で縦軸を変換します。

ロジット変換

先のデータは縦軸を死亡率、すなわち確率ととらえたときの線形確率モデルといえます。

pは死亡する確率をあらわします。

![]()

ここで、目的変数である確率は、0〜1の範囲をとります。

一般化線形モデルでは、目的変数の範囲はなるべく広い方が予測精度が高まります。

0〜1の範囲では狭すぎるので、このモデルはあまりよくありません。

そこで、死亡する確率を、死亡のオッズに変換します。

![]()

ここでpを0〜1の範囲で変化させると、オッズは0〜∞の範囲まで変化するようになります。

次いでこれの対数をとります。オッズの対数ですから対数オッズまたはロジットといいます。

![]()

これをロジット変換といいます。

![]()

こうすることにより、目的変数の範囲が、[−∞, ∞]となり、予測精度が向上するわけです。

これがロジスティック回帰モデルです。

ロジスティック回帰分析の出発点は線形確率モデルで、ロジット変換することにより、目的変数の範囲が、[−∞, ∞]となり、予測精度が向上します。

要は普通の回帰分析のYをロジットに置き換えただけと考えれば、話は簡単です。

問題としては、回帰分析では最小2乗法で回帰係数を求めますが、ロジスティック回帰分析では、等分散性が成立しないため、最小2乗法を使うことができません。

等分散性とは、どのXに対するYの分散も等しいという性質です。

両端が平坦で、中央が変動の大きいロジスティックモデルでは、等分散性は成立しないので、残念ながら最小2乗法を適用することができません。

そこで、ロジスティック回帰分析では、最尤推定法(最尤法)を適用します。

最尤推定法(最尤法)

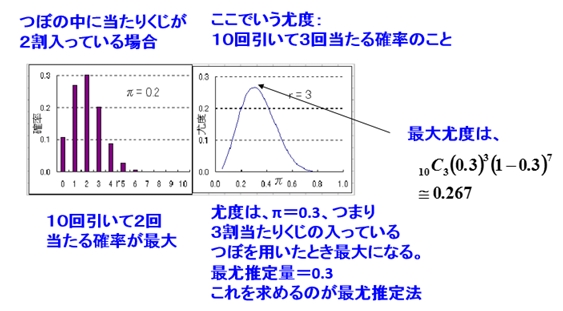

最尤推定法(最尤法)とは、読んで字のごとく尤度を最大にする推定法です。

尤度(Likelihood)というのは確率を別の見方をしたものです。

例えばくじ引きでは、つぼの中の当たりくじの数は普通決まっていて、当たる回数と確率に一定のとびとびの関係があります(下の左の棒グラフ)。

ここで見方を変えます。たとえば当たる回数を3回に固定し、つぼの中の当たりくじの数を変えてみます(10個中1個〜10個と変化させる)。

すると、つぼの中の当たりくじの数と確率が一定の連続関係をもちます(右の図)。

このときの確率は、尤度という言い方をします。

尤度最大時の当たりくじ数を求めるのが最尤推定法(最尤法)です。

この場合、10回引いて3回当たる確率すなわち尤度は10個中3個入っている場合が最大となり、その確率は0.267となります。

最尤推定量は0.3となります。

ロジスティック回帰分析では等分散性が成立しないため、最小2乗法ではなく最尤推定法により回帰係数を求めます。

最尤推定法(最尤法)の意味を理解しましょう。

ChatGPTに聞いてみた

プロンプト

あなたは最高のデータサイエンティストです。

ロジスティック回帰モデルの特徴について解説してください。

#制約条件:

サルでもわかる平易な日本語で

文字数は300字程度

ChatGPTの回答

ロジスティック回帰モデルは、ある事象が起こるかどうか(はい/いいえ)を予測するためのツールです。特に、医学で病気の有無やマーケティングで商品の購入有無など、二択の結果を予測するのによく使われます。このモデルの特徴は、出力が0から1の間の確率で表される点です。これは、単純な「はい」や「いいえ」ではなく、「どれくらいの確率ではいか?」ということを教えてくれるため、より豊富な情報を提供してくれます。また、ロジスティック回帰は線形回帰と似ていますが、出力を確率に変換するロジスティック関数(またはシグモイド関数)を使用する点が異なります。この関数のおかげで、どんなに大きな値や小さな値を入れても、出力は常に0から1の間に収まります。要するに、ロジスティック回帰モデルは、事象の発生確率を予測する際に、入力データに基づいて0と1の間の値を出力する便利な方法です。予測された確率は、その事象がどれくらいの確率で起こるか、または起こらないかを教えてくれるので、意思決定に役立ちます。